Nous sommes en 2016. Donald Trump est élu président des Etats-Unis et le Brexit promet la sortie du Royaume-Uni de l’Union européenne. Dans les deux cas, la société Cambridge Analytica, qui rassemble les données de millions d’utilisateurs Facebook pour leur adresser des messages électoraux personnalisés et influencer leurs intentions de vote, est sollicitée. À l’ère numérique, des millions de personnes ont le sentiment que leur vie privée, pourtant si précieuse, leur échappe.

Deux ans plus tard, ce sont des mails par milliers qui envahissent les messageries électroniques des Européens pour leur demander l’autorisation de continuer à utiliser leurs données. Une démarche qui vise à répondre aux exigences du nouveau règlement général sur la protection des données (RGPD). Même s’il est loin d’être parfait, ce texte servira plus tard de base à l’élaboration d’autres lois au Brésil et au Japon, et marque alors le début de l’ère moderne de la protection des données.

Toutefois, ce qui sonnait à l’époque comme le triomphe du droit à la vie privée semble aujourd’hui faire obstacle à l’ambition européenne de développer les technologies numériques, en particulier l’intelligence artificielle (IA). Face à l’opacité de cette technologie, l’Europe est-elle en mesure de protéger la vie privée de ses citoyens ?

Privilégier les droits numériques ou l’innovation ?

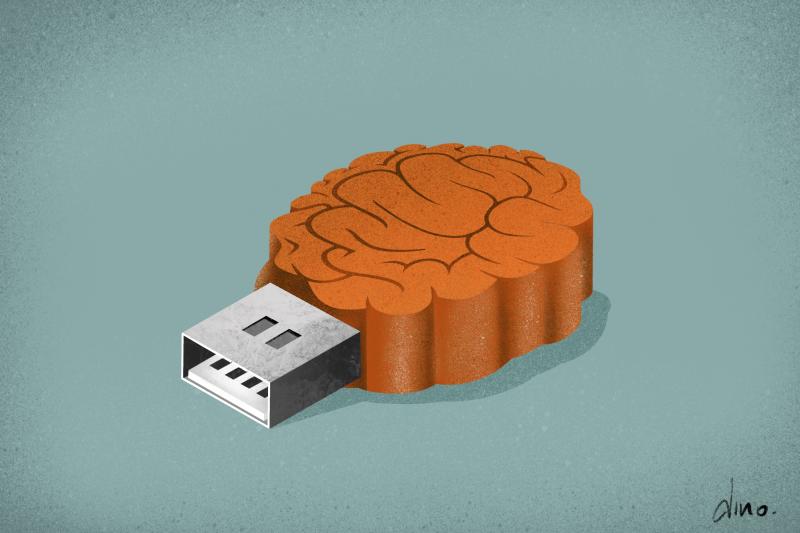

Un système d’IA est un outil informatique qui utilise des algorithmes afin d’établir des corrélations, des prédictions, des décisions et des recommandations. La capacité de l’IA à influencer les décisions humaines place cette technologie au cœur de l’économie des données.

Cet article vous intéresse ?

Il est en accès libre grâce au soutien de notre communauté. Publier et traduire nos articles à un coût. Pour continuer à vous informer en toute indépendance, nous avons besoin de votre soutien.

L’IA permet également une prise de décision plus efficace, ce qui a des conséquences géopolitiques. Les pays investissent de plus en plus dans cette technologie, marqués par la formule choc de Vladimir Poutine en 2017 : “Celui qui deviendra leader dans le domaine de l'intelligence artificielle sera le maître du monde”. En 2019, les investissements des Etats-Unis dans le secteur de l’IA avaient triplé par rapport à 2015. Quant au Japon, ils étaient douze fois supérieurs à ceux réalisés en 2015.

“Celui qui deviendra leader dans le domaine de l’intelligence artificielle sera le maître du monde” - Vladimir Poutine

Ce sentiment d’urgence a gagné d’autres domaines, tels que celui des droits numériques en Europe. Les législateurs européens ont établi des lois visant à garantir la protection de la vie privée, afin de lutter contre les monopoles exercés par les grandes entreprises technologiques, et des normes ont été établies pour garantir un stockage sécurisé des données personnelles. Ces avancées en matière de droits numériques pourraient toutefois mettre en péril la prospérité économique du continent.

Lorsque le RGPD est appliqué pour la première fois en 2018, les entreprises tirent déjà la sonnette d’alarme. Selon elles, le respect des conditions strictes de protection des données risque de faire obstacle à l’innovation technologique, et les détracteurs du texte dénoncent notamment un règlement difficile à respecter, qui réduirait la concurrence et limiterait l’apparition des “licornes” européennes, ces jeunes start-up dont la capitalisation boursière dépasse le milliard de dollars – les investissements dans ces “licornes” ayant tendance à se produire dans des marchés peu réglementés.

L’UE, de son côté, vante alors les mérites de son marché unique de plus de 500 millions de citoyens, qui garantit stabilité politique et liberté économique, et ne cesse d’attirer des investisseurs.Margrethe Vestager, commissaire européenne à la concurrence, a déclaré en 2021 que la Commission n’interviendrait concernant les usages de l’intelligence artificielle que si les droits fondamentaux des citoyens européens étaient menacés.

Réconcilier IA et vie privée

Le respect du RGPD peut représenter un obstacle supplémentaire au développement de l’IA. Les systèmes d’intelligence artificielle ont besoin d’être “entraînés” en utilisant un nombre important de données, mais les lois européennes limitent la capacité des entreprises à obtenir, partager et utiliser ces informations. En revanche, sans l’existence de ces lois, la protection de la vie privée des citoyens serait mise en péril ; afin de trouver un équilibre, le RGPD une marge de développement à l'intelligence artificielle, en employant des formulations plutôt floues pour l’European Digital Rights (EDRi), le groupe européen de défense des droits numériques, favorable à la protection de la vie privée.

Il va sans dire que cet équilibre précaire présente des aspects délicats, comme le principe de transparence, qui donne le droit aux citoyens d’avoir accès à leurs données et de savoir, en des termes concis et clairs, comment elles sont traitées. Toutefois, une telle transparence peut être difficile à maintenir, surtout lorsque des systèmes d’intelligence artificielle s’occupent du traitement des données.

Les entreprises et les développeurs d’IA se sont efforcés d’être les plus “compréhensibles” et “explicites” possibles, afin de permettre à des personnes non spécialistes du domaine de comprendre en des termes simples le fonctionnement et les prises de décisions d’un système d’IA. La tâche n’est pas aisée, puisque nombre de ces systèmes fonctionnent comme des “boîtes noires”, une expression bien connue du secteur, qui suggère que ni ceux qui construisent l’algorithme, ni ceux qui en appliquent les décisions ne comprennent réellement comment le système fonctionne.

Autre dilemme et non des moindres, celui du “droit à l’oubli”, ou droit à l'éfaccement : considéré comme une victoire du RGPD pour la protection de la vie privée, ce principe oblige les entreprises à supprimer les données de quiconque en exprimerait le souhait. Dans le cas des systèmes d’IA, une entreprise pourrait, en théorie, supprimer les données personnelles utilisées pour entraîner l’algorithme, mais le système garderait toujours la “trace” de ces données, rendant ainsi tout “effacement” définitif impossible.

Les nouvelles lois européennes sont-elles la solution ?

Même si protection de la vie privée et innovation semblent être deux notions impossibles à concilier, tout n’est pas perdu. En avril dernier, la Commission européenne a présenté sa proposition de règlement sur l’usage de l’intelligence artificielle. Lourdement critiqué sur certains points, notamment son refus d’interdire les systèmes de reconnaissance faciale, ce texte n’en reste pas moins pionnier en la matière, puisqu’il oblige les entreprises à révéler les secrets de leurs “boîtes noires”. Cette victoire pour les défenseurs de la protection des données a échauffé les nerfs de ses détracteurs, qui considèrent que les exigences de transparence freinent l’innovation et poussent les entreprises à aller voir ailleurs.

Parallèlement, les institutions européennes se sont mises d’accord en octobre 2021 sur la loi sur la gouvernance des données. Cette loi, qui couvre la réutilisation des informations, crée des “groupements de données” et des services coopératifs de partage, afin de permettre aux entreprises de profiter de l’innovation en Europe. Les entreprises seront autorisées à chercher dans ces espaces réglementés les données dont elles ont besoin, plutôt que de les acheter à d’autres entreprises ou d’avoir recours à des pratiques peu éthiques telles que les déversements de données en ligne. Cette loi fait du “don de données” un moyen de remplir ces espaces de recherche. Une vision novatrice qui va à l’encontre de l’idée généralement admise selon laquelle les données ne sont que des marchandises.

Si aucun accord n’a encore été trouvé à l’échelle mondiale, l’UE pourrait toutefois changer la donne grâce à une loi qui s’appliquerait aux 27 Etats membres d’ici 2022 ou 2023. Les systèmes d’intelligence artificielle seraient classés en fonction des risques qu’ils présentent. Par exemple, les systèmes utilisés dans le domaine de la santé seraient classés “à haut risque”, et les personnes qui conçoivent et mettent en place ces systèmes seraient soumises à des réglementations plus strictes. Pour le Comité européen de la protection des données (CEPD) et d’autres organes européens, ce nouveau cadre légal entend favoriser l’innovation. Mais il ne sera véritablement efficace que s’il parvient à résoudre les grands dilemmes posés par les notions de transparence et de droit à l'oubli.

En collaboration avec le projet Panelfit, soutenu par le programme européen Horizon 2020.

👉 L'article original sur El Orden Mundial

Cet article a été réalisé dans le cadre du projet Panelfit , soutenu par le programme Horizon 2020 de la Commission européenne.

En partenariat avec European Data Journalism Network

Vous avez eu accès à l’intégralité de cet article.

Vous voulez soutenir notre travail ? Voxeurop dépend des abonnements et des dons de son lectorat.

Découvrez nos offres à partir de 6 € par mois et les avantages réservés à nos abonné(e)s.

Je m’abonne

Ou faites un don pour renforcer notre indépendance.

Je fais un don