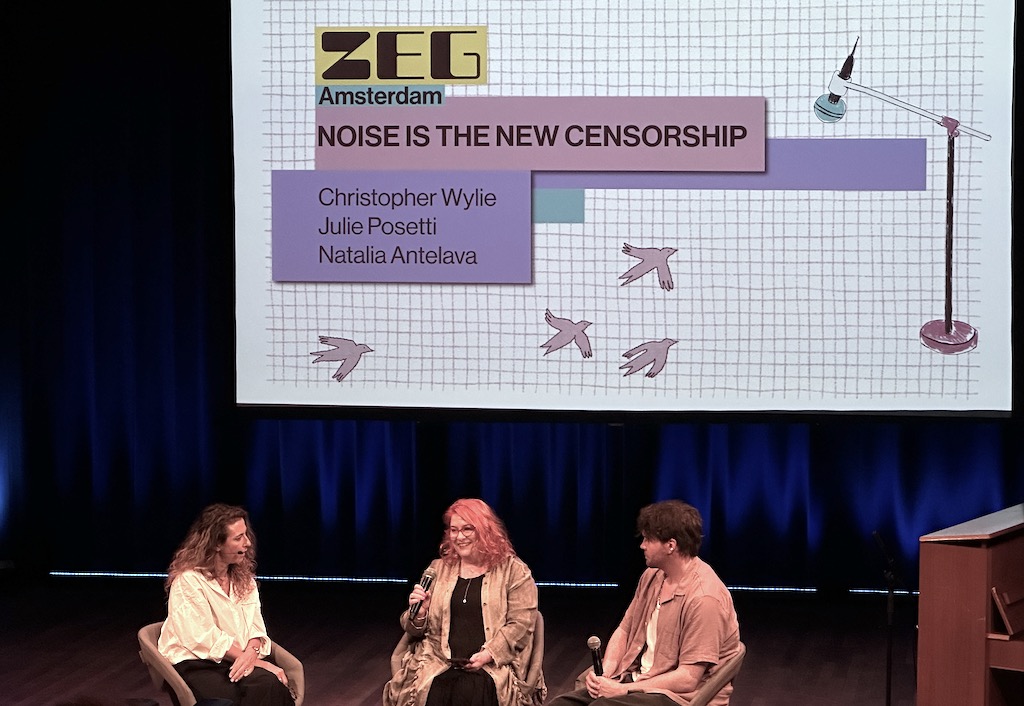

Dans un monde de plus en plus façonné par les algorithmes et les prophètes de l'intelligence artificielle, la question de savoir qui contrôle la technologie n'a jamais été aussi urgente. Lors d'une conversation organisée dans le cadre de l'événement ZEG Amsterdam, qui s'est tenu au De Balie, au cœur de la capitale néerlandaise, la journaliste et chercheuse Julie Posetti, le spécialiste des données Christopher Wylie et la journaliste Natalia Antelava ont souligné que le danger ne venait pas seulement d'un possible dysfonctionnement de l'IA, mais aussi du fait que ces concepteurs se prenaient déjà pour des dieux.

Wylie, mieux connu comme le lanceur d'alerte de Cambridge Analytica, met en garde contre le fait qu'une technologie capable de tout savoir, tout voir et tout prédire à notre sujet risque de nous priver de notre autonomie en tant qu'êtres humains : “Imaginez un avenir où tout ce qui vous entoure est contrôlé par une entité qui vous observe et réfléchit à votre place, qui peut vous voir à tout moment mais que vous ne pouvez pas voir, et qui prend des décisions pour vous. Comment pouvez-vous exercer votre libre arbitre en tant qu'individu si le monde réagit et réfléchit littéralement à votre place ?”

Selon lui, l'effet est autant intrinsèque qu’instrumental : une infantilisation rampante qui “détruit l'essence même de l'être humain”.

Sectes et technomessies

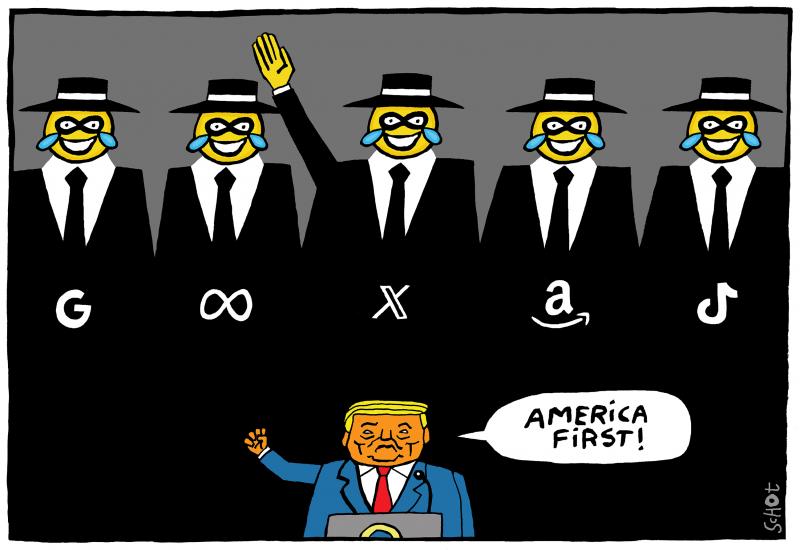

Wylie dépeint la Silicon Valley comme une “secte” moderne, animée par une idéologie mêlant ambition technologique et illusion messianique. Selon lui, des personnalités telles qu'Elon Musk (patron de X, Tesla et SpaceX), Sam Altman (OpenAI) et Peter Thiel (Palantir) parlent en termes quasi religieux de la création d'un “Dieu sur leur serveur” et envisagent un avenir transhumaniste où l'humanité évoluant vers le silicium deviendrait immortelle, omnisciente et au-delà de la moralité.

Ce n'est pas l'excentricité qui inquiète, note Wylie, mais le pouvoir détenu par les “Tech bros”: ces milliardaires convaincus de leur supposée mission de mener à la prochaine étape de l'évolution humaine exercent désormais une réelle influence politique, façonnant les lois et les démocraties sans rendre de comptes. Pour Posetti et Antelava, le fait que les médias ne prennent pas ces idées au sérieux et les rejettent au lieu d’y voir un projet politique radical, a permis à ces “sectes apocalyptiques” de se développer en dehors de tout contrôle.

Wylie réfute également l'illusion de la neutralité technologique : la technologie, selon lui, reste intrinsèquement idéologique, fondée sur des hypothèses capitalistes et individualistes occidentales qui divisent, monétisent et ségrègent les utilisateurs. Il en résulte, selon lui, une forme de “colonialisme numérique”: là où les empires du XIXe siècle exploitaient les minerais, les géants technologiques d'aujourd'hui exploitent l'attention et les données, sapant ainsi la gouvernance locale et les structures démocratiques. La véritable résistance, insiste Wylie, ne commence pas par la réglementation des grandes entreprises technologiques, mais par le rejet de leur idéologie.

Le moment européen – et ses limites

Dans ce contexte, Natalia Antelava soulève la question de la réglementation. Si la gouvernance vacille aux Etats-Unis, l'Europe, note-t-elle, est l'un des rares endroits où l'on essaie encore de responsabiliser la technologie, par le biais de mesures telles que la législation européenne sur l'intelligence artificielle (AI Act) et celle sur les services numériques (Digital Services Act) et les efforts en matière de fiscalité. “Les gouvernements se sont réveillés, dit-elle, mais peut-être est-il déjà trop tard ?”

Posetti salue certains aspects de cette stratégie, en particulier lorsqu'elle vise à “garantir un certain degré de responsabilité” et à permettre “un débat démocratique dans les espaces publics du XXIe siècle, y compris les espaces numériques”. Elle met toutefois en garde contre le fait que “nous avons en permanence un train de retard”, que “nous n'investissons pas dans les réponses nécessaires” et que certaines mesures (par exemple, l'obligation d'identification pour les moins de 16 ans en ligne) sont “tout à fait contre-intuitives”.

Le contexte géopolitique est généralement hostile : les progrès en matière de taxation équitable et de responsabilité des plateformes, note Posetti, ont été “sapés et compromis par les intimidations de Donald Trump [dans le cadre de ses] guerres tarifaires”. Le déséquilibre des pouvoirs est “pire que celui entre David et Goliath... avec toute une série de milliardaires alignés avec les législateurs américains” qui utilisent leur influence économique et diplomatique “pour contrer la réglementation européenne”.

“À l’heure actuelle, nous ne disposons pas d‘un internet conçu pour nous aider, pour nous libérer, pour élargir nos choix” – Christopher Wylie

Pour que la réglementation ait un impact, insiste Wylie, elle doit être structurelle et applicable. “Il n'y a pas d'organisme de réglementation en matière de sécurité pour les technologies. Il n'y a pas de normes pour les technologies.”

Nous vivons, de manière absurde, avec “plus de règles de sécurité pour un grille-pain dans notre cuisine que pour une plateforme qui compte un milliard d'utilisateurs”. La solution tient d’abord à une approche conceptuelle que Wylie définit comme la nécessité de “prendre vraiment du recul... Quelle est l'idéologie sous-jacente que nous voulons appliquer dans la conception ?”. Une approche responsable doit également être envisagée : “ [Il faut] associer cette réglementation à des sanctions effectives. Ce qui inclut la responsabilité pénale des dirigeants qui contribuent à des actes criminels. Si Mark Zuckerberg craignait que les autorités fédérales viennent frapper à sa porte demain, il réglerait ces problèmes.”

Wylie souligne qu'aucun de ces problèmes ne peut être résolu uniquement par le développement informatique. En d’autres mots, “la solution aux problèmes politiques est toujours politique, elle n'est pas technologique”. Pour commencer, il faut donc être en mesure de nommer le problème qu’on entend combattre. “Nous ne parlons pas vraiment de l'éléphant dans la pièce, ces leaders politiques de la Silicon Valley, qui veulent complètement saper notre société”, regrette Wylie. “Je ne pense pas que ces entreprises devraient être autorisées à exister sous leur forme actuelle", conclut-il.

Remettre la démocratie au centre du jeu

Pour les trois intervenants, le débat sur l'IA ne porte pas tant sur la technologie que sur l'état de la démocratie elle-même : qui a le droit de définir ce que sont la vérité, la capacité à agir et le pouvoir au XXIe siècle ?

Julie Posetti plaide en faveur d'un multilatéralisme renouvelé, une mise à jour du système issu de l'après-guerre fondé sur les droits humains. Face à la montée de l'autoritarisme et aux “systèmes qui asphyxient la vérité”, elle appelle à “une nouvelle approche intergouvernementale”, en demandant “quel type de réponse réglementaire en réseau, peut aller au-delà de ce que l'UE tente de faire”. Elle appelle à un nouvel effort intergouvernemental semblable à la création, après la guerre, des Nations unies et du Conseil de l'Europe. “Ces institutions sont nées d'une catastrophe, afin de garantir la démocratie, l'Etat de droit et les droits humains”, explique-t-elle. “Nous devons reconstruire quelque chose de similaire pour l'ère numérique, car seule, la réglementation nationale est vouée à l'échec.”

Wylie, pour sa part, invite à repenser les principes fondamentaux et à imaginer ce qu'il appelle, de manière provocante, un internet féministe. “À l'heure actuelle, nous ne disposons pas d'un internet conçu pour nous aider, pour nous libérer, pour élargir nos choix”, dit-il. Les méthodes dominantes d'aujourd'hui “nous séparent des autres... Cela n'a rien à voir avec la construction d'une communauté”. Réinventer le système signifie mettre l'accent sur les utilisateurs vulnérables, les dynamiques de pouvoir et les abus – un développement sous-tendu par des considérations sociales, et pas seulement commerciales.

Par-dessus tout, Wylie rejette le compromis qui a banalisé les abus : “Le prix de la facilité ne doit pas nécessairement être les droits humains. Ces deux choses ne s'excluent pas mutuellement”. Telle devrait être la ligne de conduite de l'Europe. La réglementation ne doit pas être un rempart de papier ; elle doit représenter une refonte constitutionnelle de la sphère publique numérique : des obligations claires concernant le devoir de vigilance, des normes professionnelles pour les ingénieurs en informatique, des standards de sécurité certifiés avant le déploiement de nouvelles applications et une responsabilité pénale lorsque les plateformes contribuent à causer un préjudice grave.

Pour l'instant, l'Europe fait office de terrain d'essai. La loi sur l'IA, bien qu'imparfaite, affirme un principe que la Silicon Valley a longtemps rejeté : la technologie doit être au service des citoyens, et non l'inverse. La capacité de ce principe à résister à la pression des nouveaux oligarques du numérique déterminera non seulement l'avenir de l'IA, mais aussi celui de la démocratie elle-même.

Quelle est la position de l’Europe ?

Ces dernières années, l'Union européenne a mis en place un cadre réglementaire complet en matière de numérique, comprenant la législation sur les marchés numériques (Digital Markets Act, DMA), le règlement sur les services numériques (Digital Services Act, DSA) et le règlement sur l'intelligence artificielle (AI Act), en réponse aux menaces que fait peser la Silicon Valley sur les institutions, la politique et les pratiques du continent.

Le DMA désigne six “gardiens”(Alphabet/Google, Amazon, Apple, ByteDance/TikTok, Meta/Facebook, Instagram et WhatsApp, et Microsoft) et leur impose des obligations visant à empêcher l'auto-préférence et les offres groupées anticoncurrentielles. En avril 2025, la Commission européenne a constaté qu'Apple et Meta avaient enfreint les obligations du DMA relatives à l’“anti-steering” (la possibilité offerte gratuitement aux développeurs d’applications distribuées sur l’Apple Store sans être développées par Apple de signaler aux utilisateurs l’existence d’autres plateformes de distribution) et au consentement à l’utilisation des données personnelles. En mars 2024, la Commission a lancé des procédures d'infraction contre Alphabet, Apple et Meta.

Pourquoi ces affaires sont-elles importantes ? Les obligations du DMA relatives à l'interopérabilité, aux limites à l’utilisation des données et à l'anti-steering ont une incidence directe sur la manière dont ces entreprises peuvent intégrer des assistants IA, regrouper des modèles dans les systèmes d'exploitation et utiliser les données de suivi des utilisateurs à des fins de formation (procédures de spécification IA). Le BEUC, la principale organisation européenne de protection des consommateurs, soutient la pertinence des décisions de la Commission et a salué les décisions d'avril 2025 comme étant “nécessaires pour offrir plus de choix aux consommateurs”.

À l'inverse, le DSA s'applique désormais pleinement aux très grandes plateformes en ligne (appelées “VLOP” – “Very Large Online Platforms” – par la Commission), les obligeant à évaluer et à limiter des risques systémiques comme la désinformation algorithmique ou ceux associés aux systèmes de recommandation basés sur l'IA. En mars 2024, la Commission a publié des lignes directrices sur la réduction des risques électoraux et a intégré le code de bonnes pratiques sur la désinformation dans la boîte à outils du DSA, publiée en février 2025. Les procédures judiciaires en cours dans le cadre du DSA contre X et TikTok testent les dispositions relatives aux risques algorithmiques.

En janvier 2025, la vice-présidente de la Commission, Henna Virkkunen, a souligné en outre que “la responsabilité algorithmique et le contrôle des biais sont au cœur du programme de mise en œuvre du DSA”. Dans la même ligne, le rassemblement d’organisations à but non-lucratif pour les droits numériques EDRi met en garde contre les “discours de simplification et de déréglementation” qui pourraient affaiblir les règles de l'UE.

Le règlement sur l'IA (également connue sous le nom de règlement UE 2024/1689) est entrée en vigueur en août 2024. Elle fixe trois échéances distinctes pour les entreprises utilisant l'IA. Premièrement, les pratiques présentant des risques inacceptables sont interdites à partir de février 2025. Deuxièmement, les obligations relatives aux modèles d'IA à usage général (“General Purpose Artificial Intelligence” – GPAI) s'appliquent à partir d'août 2025 ; et troisièmement, les réglementations européennes en matière d'IA concernant les systèmes à haut risque seront progressivement mises en œuvre d'ici la fin 2026 ou le début 2027.

Cela dépendra en grande partie du travail du Comité européen de l'IA récemment créé par l'UE, composé de représentants des autorités chargées de l'application de la loi des Etats membres et d'un bureau chargé de l'intelligence artificielle basé à Bruxelles. Ce dernier coordonne les autorités nationales et supervise la conformité des GPAI. Le bureau milite également pour que les actions et les politiques des Etats membres permettent de tirer parti des avantages sociaux et économiques de l'IA dans toute l'UE de manière continue, et partagent les meilleures pratiques. Il propose des cadres de test, des essais en conditions réelles et d'autres structures de soutien européennes afin d'encourager l'adoption de l'IA.

Après avoir consulté le Comité européen sur l'IA et mené une consultation publique fin 2024, la Commission européenne a publié son code de bonnes pratiques en matière d'IA à usage général à l'intention des entreprises et des autorités. Celui-ci sera régulièrement mis à jour.

Un continent prisonnier de sa dépendance ?

Cela suffira-t-il à protéger les citoyens, les entreprises et les institutions européens contre les abus ? “Les retards de mise en œuvre, la faiblesse des consultations et l'influence indue de l'industrie risquent de rendre la loi sur l'IA inefficace”, met en garde l'EDRi, l'organisme européen de surveillance de la confidentialité numérique. Une autre organisation clé de défense des droits numériques, Access Now, a exhorté la Commission à “veiller à ce que les orientations restent centrées sur les droits humains et à éviter toute mainmise de l'industrie”.

Les géants du numérique exercent une forte pression au niveau européen pour influencer les codes GPAI et les règles de transparence. Leur tâche est facilitée par le fait que l'écosystème européen de l'IA reste largement dépendant des technologies étrangères, ce qui laisse à l'UE peu de contrôle sur le modèle ou les équipements utilisés dans l'économie émergente de l'IA. Presque tous les modèles de pointe utilisés sur le continent – ChatGPT (OpenAI), Gemini (Google), Llama (Meta) et Claude (Anthropic) – sont développés et hébergés par des entreprises basées aux Etats-Unis. Leurs modèles sont également entraînés à l'aide de processeurs graphiques NVIDIA haute performance, fabriqués par TSMC à Taïwan.

Il n'est donc pas étonnant que la Cour des comptes européenne (CCE) ait averti dans son rapport spécial 12/2025 que l'Union “[était] encore loin d'atteindre l'autonomie en matière de microprocesseurs”et risquait de prendre du retard par rapport aux Etats-Unis et à l'Asie en termes d'autosuffisance dans le domaine des semi-conducteurs. De même, le rapport du Parlement européen intitulé “Faire de l'Europe un continent de l'IA”(septembre 2025) souligne la “dépendance vis-à-vis de l'étranger pour les gigafactories d'IA” et la nécessité d'investissements coordonnés dans les infrastructures informatiques et les compétences.

En bref, les modèles sont américains et les infrastructures informatiques taïwanaises. Si l'Europe se concentre sur la réglementation plutôt que sur la mise en œuvre, elle risque de rester une puissance réglementaire sans souveraineté technologique.

Tensions croissantes avec Washington

Alors que l'UE continue de faire avancer le DSA et le DMA, les tensions entre les partenaires transatlantiques s'intensifient. Donald Trump menace d'imposer de nouveaux droits de douane et de prendre d'autres mesures de rétorsion contre les pays qui adoptent des “taxes numériques” ou introduisent des réglementations qu'il juge discriminatoires à l'égard des géants technologiques américains. Une note diplomatique divulguée le 4 août révèle que les ambassades américaines ont reçu pour instruction de s'opposer activement à la réglementation numérique de l'UE. Cela a poussé les législateurs européens à dénoncer la campagne de Washington comme une atteinte directe à la souveraineté de l'Union.

Malgré la pression, Bruxelles maintient sa position. La Commission européenne a ouvert plusieurs enquêtes DSA, ciblant X (anciennement Twitter) pour ses algorithmes et ses systèmes de transparence, et identifiant des violations préliminaires de la part de TikTok et Meta pour avoir refusé l'accès à ses données à des chercheurs, ainsi que pour avoir entravé le signalement de contenus. En vertu du DMA, Apple et Meta ont déjà été condamnés à des amendes de 500 millions et 200 millions d'euros respectivement.

Dans le même temps, la France et l'Allemagne cherchent à redéfinir l'équilibre entre réglementation et compétitivité. Leur sommet conjoint sur la souveraineté numérique, qui doit se tenir à Berlin en novembre, vise à promouvoir un cadre réglementaire européen “simplifié” afin de stimuler l'innovation. Il s'agit d'une tentative d'aligner l'autonomie numérique de l'Europe sur ses ambitions économiques tout en gérant les frictions politiques et commerciales croissantes avec Washington.

| Utilisation des données d'IA dans l'UE (2022-2025) |

| Malgré les efforts politiques, l'adoption de l'IA en Europe reste limitée, mais augmente lentement. Selon Eurostat, un peu plus de 8 % des entreprises de l'UE à 27 comptant dix salariés ou plus utilisaient l'IA en 2023, contre 13,5 % en 2024, soit une augmentation de 5,5 points de pourcentage. Parmi les grandes entreprises, l'adoption a atteint 41,2 %, tandis que les PME ont oscillé entre 11 et 13 %. Au niveau de la main-d'œuvre, les premiers résultats de l'enquête européenne de Eurofound sur les conditions de travail en 2024 montrent qu'environ 12 % des travailleurs européens utilisent actuellement des outils d'IA générative dans leur travail quotidien, avec des variations nationales allant de moins de 5 % à plus de 20 %. L'opinion publique reste prudemment optimiste : une enquête Eurobaromètre réalisée en février 2025 a révélé que plus de 60 % des Européens ont une opinion positive de l'IA au travail, et plus de 70 % pensent qu'elle peut améliorer la productivité. Cependant, une écrasante majorité (84 %) souligne l'importance de maîtriser l'utilisation de l'IA afin de garantir la confidentialité et la transparence. Ensemble, ces données brossent le portrait d'un continent curieux à l'égard de l'IA, mais encore hésitant, et dont l'économie numérique continue de dépendre d'une poignée de fournisseurs mondialisés. |

🤝 Cet article a été rédigé dans le cadre du projet PULSE, une initiative européenne visant à soutenir les collaborations journalistiques transfrontalières, et en partenariat avec De Balie. György Folk (EUrologus/HVG, Hongrie), Elena Sánchez Nicolás (EUobserver) et Ana Somavilla (El Confidencial, Espagne) y ont contribué.

📺 Regardez la conversation complète entre Natalia Antelava, Julie Posetti et Christopher Wylie à De Balie.

Donnez votre avis sur le journalisme européen

Rejoignez les lecteurs et lectrices de toute l'Europe qui nous aident à améliorer notre couverture transfrontalières des affaires européennes.

Vous appréciez notre travail ?

Contribuez à faire vivre un journalisme européen et multilingue, libre d’accès et sans publicité. Votre don, ponctuel ou mensuel, garantit l’indépendance de notre rédaction. Merci !