Du 6 au 11 février 2025, Paris accueillait la Semaine de l’action pour l’intelligence artificielle (IA), événement d’envergure internationale ayant réuni chercheurs, artistes, entreprises, politiques, journalistes et société civile, où l’on a échangé sur les enjeux majeurs de l’intelligence artificielle concernant la création, l’éthique, l’économie, l’éducation et la démocratie. Conférences, débats et expositions ont rythmé cette semaine, offrant un regard croisé entre innovation technologique et réflexion critique.

Face aux Etats-Unis, leaders dans le domaine, l’union européenne souhaite à la fois encadrer le développement de l'intelligence artificielle, tout en stimulant l'innovation technologique. C’est la quadrature du cercle que tente de réaliser l’IA Act, entré en vigueur le 2 février 2025. Le texte vise à interdire les IA à risques inacceptables sur le territoire européen et de réguler les autres types d’IA à risque.

Ces journées furent également l’occasion de se questionner sur l’usage les IA génératives en lien avec l’information, notamment avec une table ronde consacrée au sujet à la BNF, et une intervention tenue à la Sorbonne sur les biais de l’IA. Alors, interrogeons-nous clairement sur l'impact de l'IA sur notre façon de nous informer et sur la manière dont les journalistes construisent désormais l’information.

Un contexte international alarmant

L’ère de la post-vérité se développe sous nos yeux alors que nous assistons à un basculement inquiétant dans notre rapport à l’information et à la vérité. Récemment par une vidéo doublée d’un communiqué postés le 7 janvier dernier, Mark Zuckerberg, patron de Meta, plongeait les médias dans une inquiétude profonde, en annonçant l’invalidation des partenariats de fact-checking, mettant brutalement fin au programme de vérification de l’information aux Etats-Unis. Un programme en lien avec des rédactions du monde entier qui avait été mis en place lors de la première élection de Donald Trump en 2016 afin de lutter contre la désinformation. Cette annonce pourrait d’ailleurs s’étendre prochainement à l’Europe, ou du moins l’affecter.

Si la déclaration du patron de Meta sonne en surface comme la volonté d’un renforcement de la liberté d’expression, elle contribue en réalité à fragiliser un écosystème médiatique déjà sous pression. Dans un contexte où les IA sont désormais capables de produire des contenus réalistes, comment lutter contre les fausses informations et le brouillage de la perception des faits ? Des experts tentent de répondre à ces questions essentielles pour le futur de l’information et le public.

Le concept de vérité et l’IA

“IA générative le grand défi de l’information”, voici le titre d’une table ronde du sommet de l’Action pour l’IA à Paris, ayant réuni François Saltiel, journaliste spécialiste des médias et du numérique, en maître de cérémonie; Julien Pain, journaliste spécialisé dans le fact-checking et présentateur de l’émission Vrai ou faux; Etienne Klein, physicien et philosophe des sciences; Françoise Soulié Fogelman, conseillère scientifique au Hub France IA; et enfin Kak, dessinateur de presse et président de Cartooning for Peace. Afin de poser le sujet, Françoise Soulié Fogelman a proposé une définition simple de l’intelligence artificielle, indiquant qu’il s’agit d’un système qui apprend à partir de données pour résoudre un problème n’ayant pas encore un algorithme pour y parvenir. En soi, l’IA générative produit des réponses basées sur la probabilité et ne cherche donc pas à s’assurer de la vérité de celles-ci.

Cela signifie qu’il est essentiel de vérifier les réponses produites : “Quand on utilise de l’IA générative, la vérité n’a rien à voir avec le système c’est nous qui devons faire ce travail-là de vérification des faits et valider que ce qui répondu est bien vrai”, précise-t-elle. Et même bien avant l’arrivée de ces nouveaux outils, cette vérification est une étape essentielle du travail du journaliste qui doit recouper son information avant de la relayer. François Saltiel rappelle que les IA répondent instantanément et se positionnent avec une certaine autorité comme détentrices de vérité sans pour autant citer leurs sources. Pourtant, si l’usager lui rétorque qu’elle se trompe, l’IA rectifie sa réponse. Son approche de la vérité semble ainsi approximative et donc peu fiable.

L’IA, accéleratrice d’information ou promotrice de fake news ?

“L’IA peut être un outil pour accélérer l’information” pense François Saltiel, journaliste de France Culture, “mais quand on parle d’IA il faut toujours revenir aux sources, et d’ailleurs c’est un réflexe journalistique, et à la définition”.

Si la désinformation existe depuis fort longtemps, la technologie aurait accéléré et amplifié ce phénomène, notamment avec l’arrivée des outils d’IA. Selon le journaliste , ces nouveaux outils agissent comme amplificateurs de nos biais. L’Académie des technologies, entité publique en charge des questions liées au numérique a publié en 2024 un rapport intitulé IA générative et mésinformation, et indique notamment que “le faux séduit davantage que le vrai car notre cerveau n’aime pas être contredit”, souligne Etienne Klein.

Le rapport précise que “les messages faux sont plus attractifs que les vrais et que l’objectif économique des grandes plateformes numériques est de maximiser les revenus publicitaires en ligne en capturant l’attention des internautes.” Les réseaux sociaux et certains médias pourraient donc être tentés par ce type de méthodes en dehors de toute considération déontologique. Evoquant Vérité et véracité, l’essai du philosophe Bernard Williams, Etienne Klein rappelle que “dans un monde bien fait le désir de véracité devrait servir à l’identification de la vérité […], or c’est l’inverse qui se produit.” L’auteur explique en effet que “le désir de véracité enclenche un esprit critique généralisé qui va se faire guider par des vérités assurées. Si je vous présente une vérité vous allez vous demander si elle n’est pas relative, contextuelle, défaite, factice, instrumentalisée etc. Et cela aboutit au paradoxe que l’on peut résumer en une phrase : le désir de véracité vient détruire l’idée même qu’il y a des vérités.”

“Dans un monde bien fait le désir de véracité devrait servir à l’identification de la vérité, or c’est l’inverse qui se produit” – Etienne Klein

Ce à quoi François Saltiel rappelle la relation existant entre le public et le média : “D’où l’importance du lien de confiance que l’on doit accorder à une source éditrice dans ce confluent de multiples vérités. C’est ainsi que les médias essaient de se définir, et soulignons qu’il faut maintenir cette relation de confiance dans un contexte où elle est abimée. Il y a une forte érosion de ce lien, et d’ailleurs la technologie y participe.” À ce sujet, Julien Pain évoque la remise en question permanente de l’honnêteté des journalistes aujourd’hui, à une période où l’on doute de tout et particulièrement de ce qui est considéré comme des élites, à savoir les politiques, les scientifiques et les journalistes.

Biais, hallucinations et aberrations de l’IA

Structurellement, l’IA générative contient un potentiel de désinformation non intentionnel (c’est à dire en marge des intentions humaines). Le rapport sur l’IA et la désinformation indique que , “l’architecture autorégressive des grands modèles de langage [Large Language Models, LLM], se prête à engendrer des hallucinations : lorsque le plus vraisemblable l’est insuffisamment, alors le rapport à la vérité se distend.”

Par ailleurs, l’IA comporte des biais humains pouvant provenir des données entrantes ou de l’entraînement. Ainsi, il faudrait mettre en évidence la ligne éditoriale de chaque LLM à l’instar des médias traditionnels, préconise le rapport. Cependant, l’IA fournit également un panel d’outils pour lutter contre la désinformation et pour prêter main forte aux fact checkers, comme vera.ai, un “projet de recherche et développement axé sur l'analyse de la désinformation et les outils et services de vérification soutenus par l’IA”.

Concernant les biais humains, Julien Pain précise que la grande question qui revient sans cesse est “est-ce que les fact checkers sont biaisés ?”. Il s’interroge donc sans cesse sur ses biais personnels. “Je suis un être humain qui a des valeurs et qui a des convictions politiques et j’essaie d’empêcher que celles-ci ne rentrent dans mon travail de fact-checker. Ce qui n’est pas simple. Mais ce qui est drôle c’est que pour l’IA on a cette impression qu’elle va être non biaisée ; or il suffit de procéder à des tests relativement simples pour constater que l’IA est pleine de biais. Je vais vous donner quelques exemples de tests que j’ai faits. Déjà, l’IA invente régulièrement. Je lui ai demandé si j’étais marié, l’IA a répondu que je suis marié avec Elise Lucet, alors que je ne suis pas du tout marié. Quand elle n’a pas de réponse à donner, l’IA invente la réponse en produisant une hallucination.”

Concernant les biais de l’IA plus précisément, Julien Pain avoue avoir testé Grok, l’outil d’IA du réseau social X. Le journaliste a réalisé un prompt sur Silvano Trotta, complotiste connu avançant que la Lune est un astre artificiel creux : “Je pose la question à l’IA ‘est-ce que Silvano Trotta est fiable ?’”, dit-il, “Pour un humain la réponse est simple si quelqu’un dit que la lune est creuse on n’a pas besoin de dire toute une tartine là-dessus. Et là l’IA me répond ‘on peut considérer qu’il n’est pas fiable car effectivement les scientifiques remettent en question certaines des choses qu’il dit. En revanche, on peut aussi apprécier ce qu’il dit parce qu’il remet en question le consensus et il propose une voix dissonante contre la pensée dominante’. Mais quelle est cette réponse ? Maintenant, dire que la Lune est creuse, c’est allé contre la pensée dominante ?”

L’IA peut en effet potentiellement aller à l’encontre de faits scientifiques avérés afin de se montrer modérée dans ses réponses et ne pas offenser ses utilisateurs. Ce type de comportement artificiel contribue à changer le rapport du lecteur à la vérité. Le journaliste qui a également testé Deepseek l’outil d’intelligence Made in China, a répertorié également un certainement nombre de biais, bien évidemment sur les questions des Ouighours et du Dalaï Lama, mais aussi sur des réponses timorées concernant Vladimir Poutine pour savoir si ce dernier est un dictateur. L’IA aurait répondu qu’il le serait un peu mais qu’il pouvait aussi être considéré comme un leader pour certains. Julien Pain a posé la même question au sujet de Mao et au moment où l’IA commençait à répondre, elle a bugué au milieu de la phrase et a indiqué qu’elle est désolée mais qu’elle ne peut pas répondre à cette demande.

Au sujet des biais et des aberrations visuelles, nous avons pris la parole dans un séminaire que nous avons organisé à la Sorbonne sur les IA créatives afin d’expliquer comment l’IA répondait aux prompts, c’est à dire aux demandes écrites pour générer des visuels. Dans le cadre d’une commande de visuels de féministes que nous avons effectuée auprès d’IA génératives, nous avons pu constater différents biais de la part de celle-ci. En effet, les images générées montraient principalement des femmes jeunes, fines, plutôt blanches et dans une posture parfois agressive.

Cela relèverait-il du “code gaze” notamment mis en exergue dans les travaux de Joy Buolamwini, chercheure au MIT, autrice du célèbre Unmasking AI (“Démasquer l’IA”, Random House Trade, 2023) ? Buolamwini relève les biais algorithmiques liés à la fois à l’entraînement de données biaisées mais aussi des biais les préférences de ceux qui ont le pouvoir de choisir sur quels sujets se focaliser. Elle explique que “le regard codé décrit la manière dont les priorités, les préférences et les préjugés de ceux qui ont le pouvoir de façonner la technologie peuvent propager des préjudices, tels que la discrimination et l’effacement. Nous pouvons coder des préjugés dans la technologie même si ce n’est pas intentionnel”, comme la couleur de peau, la silhouette ou l’âge.

IA et dessin de presse

Dessinateur de presse, KAK avoue s’interroger avec ses pairs sur l’IA qu’ils/elles représentent régulièrement : L’IA questionne comme “enjeu de société sur la défense des droits humains, le combat des plus faibles contre les plus forts, mais elle nous interroge aussi comme potentielle concurrente.” Selon lui, L’IA peut facilement répondre à la demande d’illustration : “L’illustration en dessin de presse signifie que vous ne cherchez pas une idée, on nous dit par exemple ‘On va faire un article sur le système bancaire, dessine moi un hall avec des guichets’. Il n’y a pas d’idée, il s’agit juste d’une illustration.”

Cela pose tout de même la question du remplacement de l’humain, rappelle-il, qui ne sera plus payé pour cette tâche. En revanche, pour le dessin d’actualité, c’est une autre paire de manches, car ces outils se montrent encore inefficaces, même si l’auteur note des améliorations récentes. Il donne un exemple précis : “J’ai demandé à Firefly de me faire un dessin de presse sur la déclaration de Donald Trump indiquant qu’il allait vider Gaza de ses habitants et l’administrer par les Etats-Unis. Dans un premier temps, l’IA générative de dessin bugue et ne comprend pas de quoi je parle. Elle ne comprend pas la consigne et fait n’importe quoi. Donc, j’ai décidé d’opérer différemment et j’ai demandé à chatGPT de m’écrire un prompt pour l’IA générative de dessin. Et ça marche très bien dans ce sens-là. ChatGPT m’a suggéré une idée de dessin qui n’était pas géniale mais qui se tenait, en proposant une carte géographique sur laquelle il y aurait Donald Trump et plein de petits drapeaux américains dessus, et où il dirait à des Palestiniens 'je vais trouver un endroit pour vous reloger'. C’est pas hilarant mais c’est un dessin de presse. Je me suis rendu compte qu’en termes d’idées, l’IA a beaucoup avancé.” Précisons que certaines IA rechignent à représenter les politiques ou des sujets polémiques ce qui peut être handicapant dans la réalisation d’un dessin politique.

“L’IA n’est pas capable, dans la génération de dessin de presse, de rendre compte d’une connaissance du contexte, du second degré, éventuellement du cynisme et de l’humour” – KAK

KAK estime que le métier de dessinateur d’actualité n’est pas encore menacé : “parce qu’il faut avoir une connaissance de l’actualité du jour et l’avoir digérée, et il faut être capable ensuite de faire de la parodie, voire de l’irrévérence, parfois même de la provocation, c’est d’ailleurs ce que l’on fait souvent dans notre travail. Or beaucoup d’IA commencent à être lissées pour ne pas aller dans ces axes-là. L’IA n’est pas capable, dans la génération de dessin de presse, de rendre compte d’une connaissance du contexte, du second degré, éventuellement du cynisme et de l’humour. L’IA ne comprend pas l’intention, le contexte et ce qui constitue une certaine forme de caractéristiques de l’humain.”

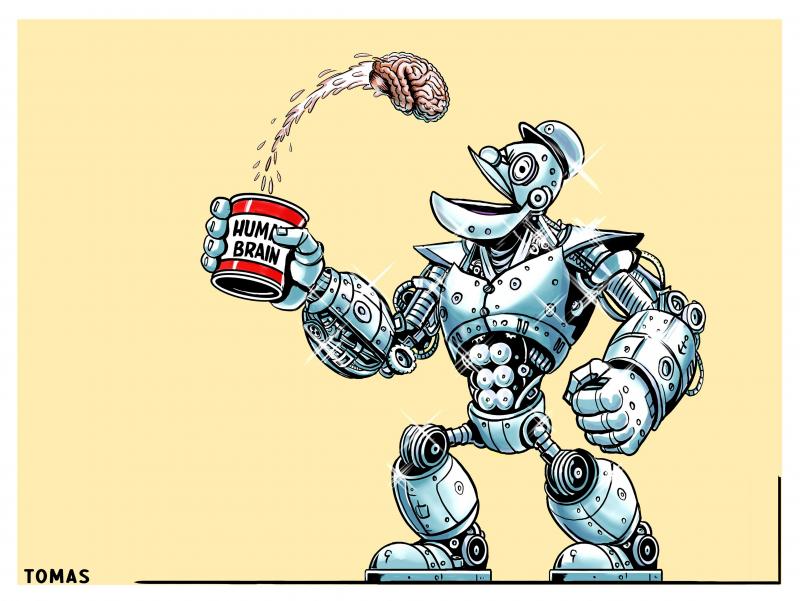

Deepfakes : la menace fantôme ?

Un deepfake est une technique d'IA qui génère ou modifie des contenus visuels hyper-réalistes (vidéos ou images). Elle permet de changer les voix et les visages pour simuler des actions ou propos fictifs, imiter la voix d’une personnalité ou lui prêter des actions qu’elle n’a pas effectuées. Couramment utilisé sur les réseaux sociaux, le deepfake peut constituer un puissant outil de désinformation.

Françoise Soulié Fogelman rappelle que “L’IA n’est pas intelligente, ça n’a pas d’esprit […], ça apprend sur les données du web et après on l’aligne sur nos valeurs. C’est pour cela qu’il est très important qu’en France et en Europe, nous ayons des IA qui nous appartiennent parce qu’elles doivent répondre à nos valeurs et pas celles des chinois ou des américains.” D’autant que “l’IA augmente la qualité de l’offre en matière de faux”, rappelle Etienne Klein.

Le deepfake a déjà produit des catastrophes dans le monde de l’entreprise dont l’exemple le plus célèbre est Arup, une multinationale britannique victime de fraude à Hong Kong qui a ainsi perdu 25 millions de dollars ! Les fraudeurs ont créé une fausse visioconférence à partir de l’IA et en usurpant l’identité d’un dirigeant afin d’inciter un employé à réaliser des virements. En l'occurrence, c’est le lien de confiance qui est rompu avec l’usage de la technologie.

Le rapport Reuters de 2024 indique clairement que l’utilisation de l’IA dans les médias suscite la méfiance et l’inquiétude chez les citoyens de plusieurs payes. “Bien que l'IA puisse être un atout pour les rédactions, elle semble également susciter une méfiance croissante chez les citoyens. Pour rédiger ce rapport, Reuters a mené des enquêtes auprès de 100 000 personnes dans 47 pays, permettant ainsi de mettre en lumière les défis auxquels font face les médias en ce qui concerne leurs modèles économiques et l'utilisation de l’IA.” indique le principal auteur du rapport, Nic Newman.

Françoise Soulié Fogelman précise qu’il n’existe pas d’outils permettant de déterminer si une image est fausse “mais l’IA peut devenir un remède au poison ! S’il n’y a pas de watermark invisible sur une image apposée par celui qui l’a produite, on ne peut pas détecter une image générée par l’IA. C’est là tout le problème, nous sommes incapables de vérifier la vérité d’une image. Est-ce que l’IA peut quand même aider ? Quand on doit faire face à un flot d’évènements qui se produisent, on ne sait plus traiter. La cybersécurité est dans la même situation que l’information : Jusqu’ici on savait traiter le phishing (hameçonnage) et les attaques. Quand il en arrive un, on sait traiter, quand il en arrive mille on ne sait plus le faire. La seule façon de se défendre des attaques massives générées par l’IA, c’est de mettre en face des IA qui vont pouvoir avaler massivement des volumes de données fournies. Est-ce qu’une IA pourra traiter un milliard d’images dont certaines sont fausses en dix secondes, non, puisqu’elle ne sait pas détecter qu’une image est fausse mais elle pourra les avaler. On arrivera petit à petit à produire des IA capables de donner un pourcentage de possibilité qu’une image soit fausse. Elle pourra traiter une grande quantité d’images à le seconde sur ce mode, ce qu’un humain ne peut pas faire.”

Mais alors, est-ce à dire que nous allons devoir déléguer notre fact-checking en raison du volumes des données à traiter ? Ne risquons-nous pas de perdre notre esprit d’analyse, et surtout questionnons nous sur ce point : avons-nous envie de laisser le soin à une machine de dire si oui ou non des informations sont potentiellement vraies ? Quid d’un bug, d’un biais, d’une incompréhension, d’un manque d’analyse contextuel etc. que l’on perçoit déjà dans l’usage des LLM ?

“La seule façon de se défendre des attaques massives générées par l’IA, c’est de mettre en face des IA qui vont pouvoir avaler massivement des volumes de données fournies” – Françoise Soulié Fogelman

Pour lutter efficacement contre les deepfakes, certains piliers de l’information musclent leurs méthodes. Ainsi, l’AFP (Agence France-Presse) rappelle la véracité des photographies par le biais des négatifs, plaques de verre, des documents uniques prouvant l’origine d’une image. Directeur adjoint de l'information de l'AFP en charge de la photo, du graphisme, de la documentation et des données, Eric Baradat se veut rassurant : “avec l’apparition de l’IA générative, notre profession fait face à la menace d’une perte de la confiance construite avec son public. Dans un monde où la manipulation numérique est devenue si simple, les acteurs du numérique et les médias, ont mis au point un standard pour certifier les images”, dit-il dans une vidéo présentant cette certification nommée C2PA (Coalition for Content Provenance and Authenticity).

Ce marquage indestructible et permanent est invisible pour le public mais consolide la véracité de l’image : “Avec un appareil doté du standard C2PA, le photographe prend une photographie, ajoutant une signature numérique sécurisée dans le fichier de l’image durant la prise de vue. Il transmet sa photo à l’AFP. Le fichier original est stocké dans un endroit sécurisé tandis qu’un duplicata est envoyé au desk photo de l’AFP pour la procédure habituelle. Finalement, juste avant que la photo ne soit livrée aux clients de l’AFP, l’image est tatouée avec un marquage individuel, encrypté et invisible. Maintenant, imaginez que vous voyez une photo dans les médias ou sur les réseaux sociaux, que vous voulez vérifier. Avec l’extension WeVerify sur le navigateur Chrome, largement utilisé par les fact-checkeurs depuis des années, vous pouvez facilement décoder le marquage, qui renvoie à l’image de l’AFP et au fichier original certifié. Cela comme si vous examiniez un négatif.”

Pour Julien Pain, il y a deux sujets d’inquiétude actuellement : d’une part les deepfakes capables d’imiter très facilement la voix des gens ou leur image. “Et la seconde chose qui me semble plus inquiétante, c’est la capacité de l’IA à créer très facilement des faux sites d’information avec des bots qui vont ensuite interagir.” Il évoque un événement récent montrant que “l’IA permet d’industrialiser les processus de création de fausses informations ou de propagande. […] Concernant les élections législatives allemandes [du 23 février], il y a un ancien marine américain prorusse qui a créé une galaxie de sites internet avec de la propagande en allemand à destination d’un public allemand en critiquant bien sûr le parti écologiste, la gauche allemande, avec beaucoup d’arguments sur l’immigration etc. Là, où avant il fallait des armées d’internautes pour arriver à ce résultat, à créer ces sites, à les entretenir, à pousser ces contenus sur les réseaux sociaux, là il était tout seul ou presque, et simplement avec de l’IA, et avec très peu d’argent et très peu d’efforts, il a créé cette galaxie de sites internets pour le public allemand dans le but d’influencer l’élection.”

“l’IA permet d’industrialiser les processus de création de fausses informations ou de propagande” – Julien Pain

En décembre 2024, c’est l’élection présidentielle roumaine qui suscitait la stupeur, avec l’essor du candidat prorusse Călin Georgescu, dont toute la campagne a été réalisée par le biais de manipulations numériques sophistiquées. Et de manière générale, on note une amplification de ces phénomènes par l’usage de hashtags, le financement d’influenceurs alliés à des outils capables de booster une personnalité politique dans les sondages, avec des répercussions électorales potentielles.

Julien Pain souligne la disproportion entre la taille des équipes qui se consacrent à la vérification des contenus générés par l’IA et la puissance d’action de l’IA : “On est dans une situation déséquilibrée entre des gens qui sont censés comme moi travailler sur la désinformation via le fact-checking, et en face des logiques industrielles. Vous imaginez qu’avec une équipe de cinq journalistes, si en conférence de rédaction du matin on se retrouve avec des milliers et des milliers de fausses informations, on n’a pas la capacité de répondre à tout ça et on ne peut pas contrer ces phénomènes là. Ici il y a une asymétrie avec d’un côté une puissance de calculs colossale et de l’autre des moyens d’y répondre faibles, sachant que le temps qu’on passe à identifier une fausse information est capital, que ça prenne 24 heures ou 3 heures ou 6 heures.”

Du bon usage de l’IA dans la fabrique médiatique

Alors, face aux multiples dangers de mésinformation évoqués plus haut, quelles solutions peut-on prôner pour s’assurer d’avoir une information de qualité ? Julien Pain estime que “le problème de notre société actuelle réside dans le fait qu’on est en train de décrédibiliser tous les experts. Il faut savoir qu’à l’heure actuelle, pour déceler le vrai du faux, il existe des outils d’IA à qui l’on confie des images pouvant nous dire s’il y a des indicateurs pour signifier que l’image aurait pu être générée par l’IA. Mais on n'est qu’au début de cela. Et ces indicateurs ne restent que des indicateurs. Donc, beaucoup d’images passent au travers. Par ailleurs, plus les IA se perfectionnent, plus elles vont réussir à passer le test. Je ne pense pas tellement que la technologie va nous sauver sur ce point. Je ne crois pas non plus que même si on augmente le niveau d’éducation des gens, on ne pourra pas non plus apprendre à tout le monde comment fonctionne un vaccin ARN car il nous manque un niveau de connaissances techniques, scientifiques. La seule façon de s’en sortir selon moi est de rétablir un lien de confiance avec l’expertise.” François Saltiel rappelle que “dans l’IA Act, il y a cette volonté de transparence des données. Mais là nous sommes face à un débat entre d’un côté les acteurs qui vont se cacher derrière le secret de fabrication des ‘produits industriels’ pour ne pas révéler les outils des ingrédients utilisés. Or, ce n’est pas la recette algorithmique que l’on veut connaître ; on demande juste à savoir quelle est la matière première. L’idée de s’inspirer du nutri-score alimentaire est donc sur la table, comme l’idée des quotas, parce que l’on veut savoir quelle part de produits synthétiques a été utilisée dans l’information que l’on consomme.”

Françoise Soulié Fogelman a un avis plus modéré sur la question et soulève un problème intéressant, à savoir “qu’avec les techniques actuelles de l’IA, on va donner un nutri-score. Or, l’IA a cette propriété que la recherche avance extrêmement vite. Il y a des milliers de publications sur l’IA par semaine. Donc si aujourd’hui tu as le nutriscore B, demain rien ne dit que tu n’aurais pas le nutriscore D ou E son les avancées. Ce qui n’est pas la cas des gâteaux !”

Selon Kak, le combat sur la crédibilité des médias et des sources sur internet a commencé bien avant l’arrivée de l’IA : “toute la question réside dans la crédibilité de la personne à qui on délègue ce savoir. On voit bien qu’il y a un bras de fer planétaire accéléré par la post vérité, l’ère post-Trump, où on présente des faits alternatifs (un bel oxymore). Il y a donc un combat énorme de ceux qui luttent contre la désinformation, y compris les chefs d’états de certains pays, pour décrédibiliser les sources qui jusque là étaient plutôt admises comme à peu près fiables, avec tout un vocabulaire qui a été mis en place de ‘discours dominant’, média mainstream’, ou ’le système’ qui ont pour but de décrédibiliser les sources officielles. Le plus gros enjeu pour moi c’est la façon dont on va conserver une crédibilité.”

Alors, avec les IA et l’ère de la post-vérité, est-ce la fin de l’intelligence collective ? Une solution à prendre en compte pour apprécier l’information, et ce avec ou sans les IA, serait effectivement en tant que lecteur et lectrice d’aborder avec modestie certains sujets sur lesquels nous n’avons pas d’expertise et effectivement de ressouder ce lien de confiance avec les spécialistes d’un domaine qui ont étudié le sujet pendant des années et mènent des recherches sur celui-ci, sans vouloir sans cesse rivaliser en superposant un avis peu éclairé à un avis scientifique, par exemple. Il est peut-être plus rigoureux aujourd’hui de faire confiance à une parole humaine éclairée qu’à un LLM.

Pour finir, les rédactions utilisent certaines IA de manière saine, car elle présente aussi beaucoup d’avantages. Quand un journaliste réalise une interview qu’il doit retranscrire, cela prend des heures. En confiant la transcription à une IA, le texte est rédigé rapidement et le journaliste génère ainsi un gain de temps qu’il peut investir ailleurs. Certes, il peut y avoir des coquilles mais lorsque l’enregistrement est bien réalisé, le texte rendu est correct.

KAK évoque aussi l’audiolisation : “on peut faire écouter les articles aux gens car ils aiment de moins en moins lire. À L’Opinion, la voix que vous entendez est celle du journaliste qui a écrit l’article. Tous les journalistes ont lu trois minutes d’un texte lambda à une IA qui a copié nos voix et lit avec elle nos textes. Donc c’est du deep fake mais utilisé pour le plaisir du lecteur qui sait que c’est la voix du journaliste ayant écrit l’article qui lui lit le texte. On utilise aussi l’IA pour la traduction d’articles, ce qui est pratique pour les rendre accessibles à des publics qui ne savent pas lire la langue d’origine. L’Opinio a publié l’été dernier des séries d’articles écrites par l’IA tout en en informant le lecteur, pour des papiers pédagogiques sur l’Europe comme par exemple : Qu’est-ce que le rôle la commission européenne ? Quelle est l’autorité du parlement sur la commission ? Ils avaient à la fois des analyses de journalistes et un texte pédagogique à côté qui leur évitait d’aller chercher sur Google.”

Vous appréciez notre travail ?

Contribuez à faire vivre un journalisme européen et multilingue, libre d’accès et sans publicité. Votre don, ponctuel ou mensuel, garantit l’indépendance de notre rédaction. Merci !