Dieser Artikel ist nur für Abonnent*innen von Voxeurop zugänglich

Schauen wir uns die nächsten fünf bis zehn Jahre an, in denen KI und Sensoren buchstäblich in alles integriert sein werden: Wir sehen einer Ära entgegen, in der Sie nach Hause kommen, im Wohnzimmer Ihren Fernseher einschalten, und während der Fernseher Sie beobachtet, spricht er mit dem Kühlschrank, dem Toaster, Ihrem Schlafzimmer, Ihrem Badezimmer, Ihrem Auto und Ihrem Briefkasten. Sie werden also in Ihrem privatesten Umfeld ständig beobachtet, und um Sie herum findet eine stille Unterhaltung statt. Im aktuellen wirtschaftlichen Kontext sollen Sie als Verbraucher optimiert werden.

Mit dieser Konversation zwischen den Geräten wird der Zweck verfolgt, dass diese Ihnen Dinge zeigen sollen, um Sie zu einem besseren Kunden zu machen. So werden Sie letztendlich Ihrer grundlegenden Handlungsfähigkeit beraubt, weil Entscheidungen für Sie getroffen werden, ohne dass Sie daran beteiligt sind.

Dies führt zu der wirklich grundlegenden Frage über das Menschsein in digitalen Räumen. In der Natur beeinflussen uns die Dinge, aber das Wetter oder die Tiere versuchen nicht, uns zu schaden. Aber wenn man in einer Stadt spazieren geht, in der die Stadt selbst darüber nachdenkt, wie sie einen optimieren kann, wird man zu einem Teilnehmer in einem Raum, der versucht, einem seine Entscheidungen zu diktieren. Wie können Sie freie Entscheidungen treffen, wenn die Stadt um Sie herum, die Gebäude um Sie herum, die Geräte um Sie herum – buchstäblich alles – versucht, mittels einer Vorauswahl zu bestimmen, was Sie sehen, um diese Entscheidung zu beeinflussen?

Wie kommt man aus diesem Raum wieder heraus, wenn man einmal dort ist, wo man beobachtet wird? Wie können Sie Ihre Autonomie als Mensch ausüben? Das wird ganz einfach unmöglich. Wir müssen wirklich anfangen, darüber nachzudenken, was wir mit KI aufbauen, in was wir uns hineinbegeben, denn wenn wir diesen Raum einmal geschaffen haben, gibt es keinen Ausweg mehr.

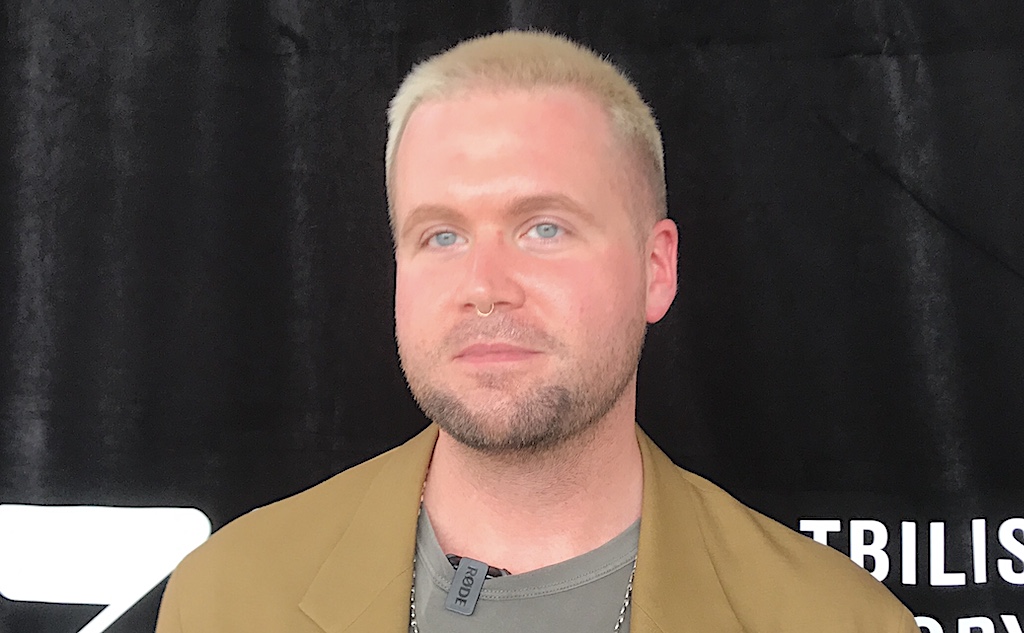

Aus diesem Grund müssen wir die KI regulieren – und zwar schnell. Wenn wir uns anschauen, wie wir andere Sektoren regulieren, dann formulieren wir als erstes eine Reihe von Schäden, die wir vermeiden wollen. Bei Flugzeugen wollen wir nicht, dass sie abstürzen; bei Medikamenten wollen wir nicht, dass sie Menschen vergiften.

Es gibt eine Reihe von Schäden, von denen wir bereits wissen, dass die KI zu ihnen beiträgt, und die wir in Zukunft vermeiden wollen: z. B. Desinformation, Täuschung, Rassismus und Diskriminierung: Wir wollen keine KI, die zur Entscheidungsfindung mit rassistischen Vorurteilen beiträgt. Wir wollen keine KI, die uns betrügt. Der erste Schritt besteht also darin, zu entscheiden, was die KI nicht tun soll. Der zweite Schritt besteht darin, ein Testverfahren zu entwickeln, damit die Dinge, die wir verhindern wollen, tatsächlich nicht passieren.

Wir testen Flugzeuge auf mögliche Schwachstellen, damit sie nicht vom Himmel fallen. Wenn wir also nicht wollen, dass ein Algorithmus falsche Informationen verstärkt, müssen wir einen Weg finden, dies zu prüfen. Wie ist er aufgebaut?

Welche Art von Eingaben verwendet er, um Entscheidungen zu treffen? Wie verhält sich der Algorithmus in einem Testbeispiel? Das Durchlaufen eines Testprozesses ist ein sehr wichtiger Aspekt der Regulierung. Stellen Sie sich vor, die Entwickler stellen vor der Freigabe fest, dass ein von einer Bank verwendeter Algorithmus eine rassistische Verzerrung aufweist und beim Test an einer Versuchsgruppe mehr Hypotheken an hellhäutige als an dunkelhäutige Menschen vergibt. Wir haben das Risiko bewertet und können nun zurückgehen und den Algorithmus korrigieren, bevor er freigegeben wird.

Es ist relativ einfach, KI nach demselben Verfahren zu regulieren, das wir auch in anderen Branchen verwenden. Es geht um Risikominderung, Schadensbegrenzung und Sicherheit, bevor die KI für die Öffentlichkeit freigegeben wird.